Enbeddings from Language Models:文脈を考慮した分散表現を得る手法。

一つの単語に一つの意味しか持たせられませんでしたが、ELMoではDeepなネットワークで学習することにより、文脈に応じた単語の意味を表すことが可能になります。

どうするかというと、例えばWord2Vecは周辺に出現する単語の傾向から対象となる単語の埋め込み表現を求めていましたが、ELMoでは、その対象となる単語が含まれている文章全体がインプットとなり、その文章によって単語の意味、つまり埋め込み表現が変わってきます。

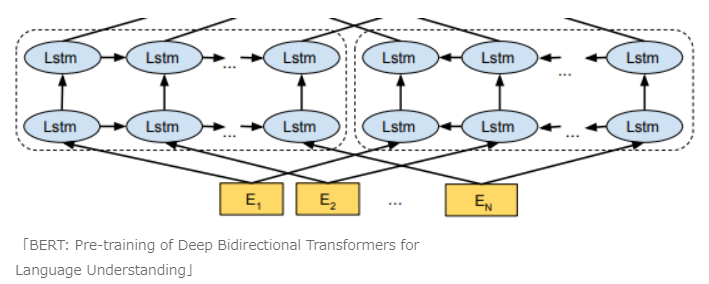

ELMoは、双方向言語モデルの中間層による単語の表現です。

つまり、またBERTの図を拝借すると、以下の各単語に対応するLSTMの隠れ層の値やEmbedding層の値の平均を取ったり、重みづけしたりして、得られるベクトルが、その単語のDeepな埋め込み表現となります。