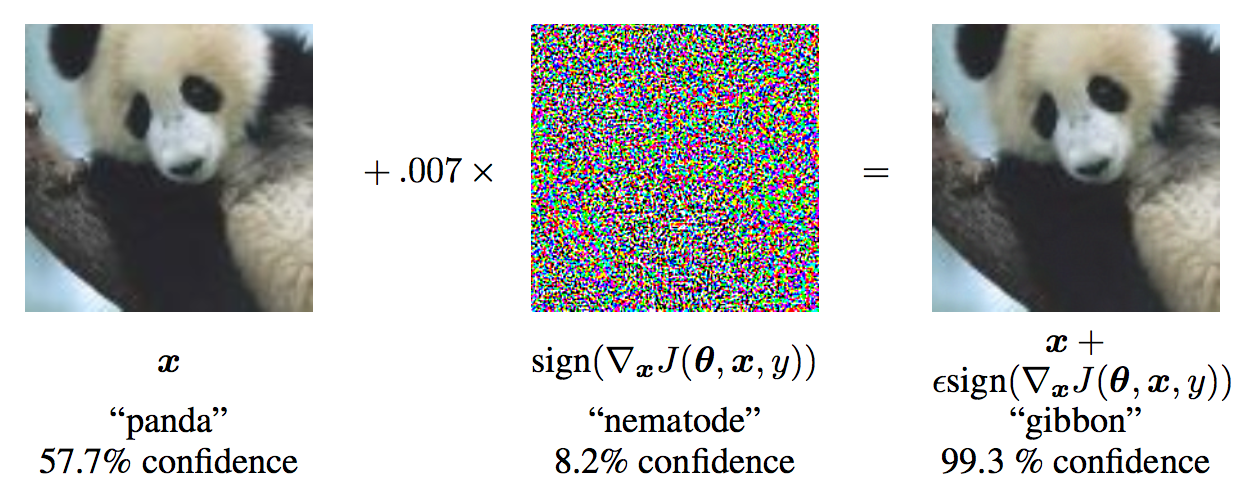

深層学習においてモデルが不可解な挙動を引き起こすノイズを加えた分析対象。モデルの脆弱性を突くことを意図してノイズを加えることを Adversarial Attackと呼ぶこともある。

Adversarial exampleというのは、下図のように摂動を与えることによりモデルに間違った答えを出力させてしまうもののことです。 この例では、もともとモデルがパンダと正しく分類することができていた画像に摂動を与えることで、テナガザルと誤分類させています。 しかし、人間には元の画像との違いはほとんど分からず、パンダのままに見えます。