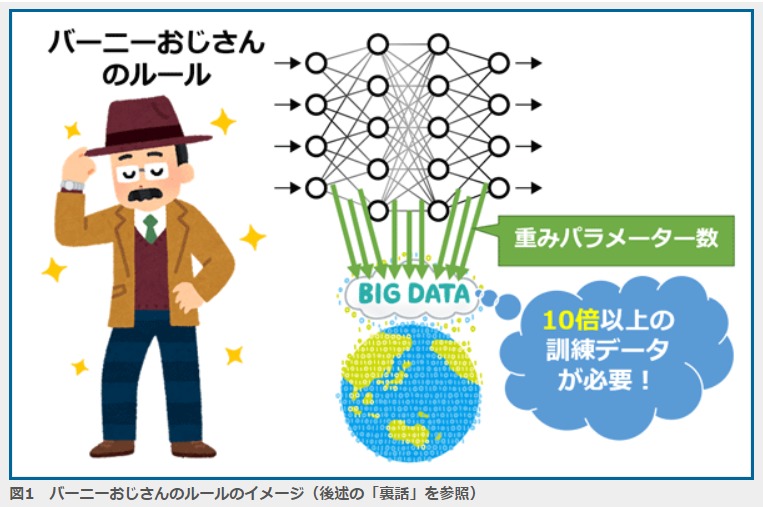

機械学習において学習に必要なデータ数は説明変数(パラメータ)の数の10倍になるという感覚を表す用語。

機械学習におけるバーニーおじさんのルール(Uncle Bernie’s rule)とは、ニューラルネットワークの重みパラメーターの数に対して、最低限その10倍以上の訓練データ量が必要となる、とする経験則のことである。訓練データの数量の目安とされるが、定理ではなく、あくまで経験則である。その出典(後述)も古く(=最近のディープラーニングに適用できるかどうかは不明で)、数学的に証明されているわけでもないので注意が必要だ。